ビッグデータ解析とは、大量のデータから役に立つ情報を抽出する技術・手法です。「ビッグデータ」という言葉は1990年代にNASAの科学者達の論文で目立つようになった言葉で、一般的には2008年のWEB2.0の発展とともに認知が広がりました。

ビッグデータ解析がSCMで重要な点としては、ビッグデータというくらいにサプライチェーンに関連する情報は非常に膨大になっているということです。モノの最上流から消費の終了までという長く複雑なサプライチェーンにおいて、どこにどれだけモノがあるのか、どれだけ需要があり、どういう制約条件に基づいて発注量を決めれば最適なのか、必要な情報がそもそも多すぎるということです。

ビッグデータ解析は、その言葉の登場時には「データサイエンティスト」というような分析専門家の活用とセットで語られました。現在は、人工知能の発展によって、どうやってAIにデータを解析させるのかということが重要になっていると思います。

AIの強みは、再現性があること、ずっと働き続けられることですので、ビッグデータ解析とはAIのためにある仕事です。

ビッグデータ解析を行うことは、サプライチェーンの強靭化のために避けては通れない一つの道といえます。

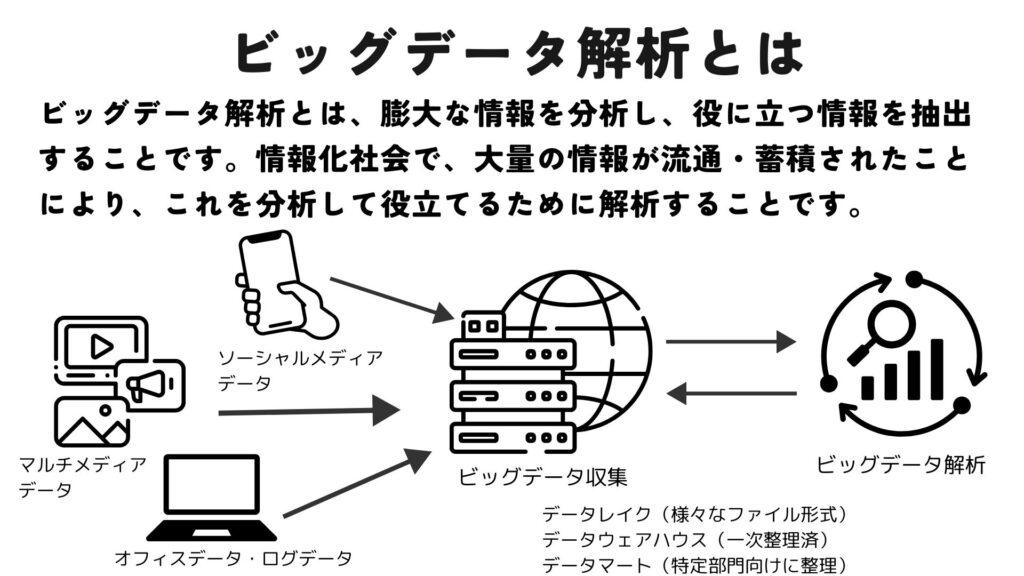

ビッグデータの関連用語として、格納場所については以下のように使い分けられています。

・データレイク:様々なファイル形式で、とりあえずなんでも保存する場所

・データウェアハウス:分析がしやすいように形式をそろえて一元管理する場所

・データマート:特定部門・業務のために整理して管理する場所